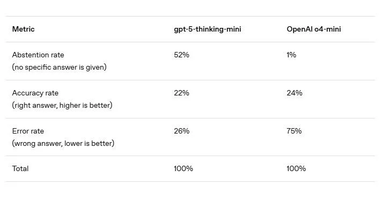

OpenAI досліджує, чому навіть найкращі моделі ШІ галюцинуютьOpenAI представив результати масштабного дослідження про те, чому великі моделі мови ШІ, такі як GPT-5, продовжують галюцинувати, і чи можна з цим щось зробити. Автори порівнюють нейронні мережі зі студентами на іспиті: якщо відповідь «Я не знаю» приносить нуль балів, вигідніше ризикнути і дати хоча б якусь відповідь. Цей метод заохочує галюцинації, оскільки залишає невеликий шанс, що ШІ вгадає правильну відповідь. На думку авторів, причина криється в самій системі оцінювання. Популярні бенчмарки — від MMLU до SWE-bench — використовують бінарний принцип «правда/хиба». В результаті моделі змушені вгадувати, а не чесно визнавати невизначеність. Це чітко видно в таблиці нижче:

Источник: news.finance.ua